En 2025, le rythme des changements réglementaires est tel que les équipes conformité font face à un déluge de nouvelles obligations – en finance, on recense jusqu’à 234 alertes réglementaires par jour, un volume 25 fois supérieur à celui d’il y a dix ans

L’écosystème Gouvernance, Risques et Conformité (GRC) vit une mutation profonde sous l’effet conjugué de la transformation numérique et d’une pression réglementaire sans précédent. Des réglementations telles que le RGPD ou le nouveau Digital Operational Resilience Act (DORA) imposent aux organisations des exigences de résilience et de protection toujours plus strictes. En 2025, le rythme des changements réglementaires est tel que les équipes conformité font face à un déluge de nouvelles obligations – en finance, on recense jusqu’à 234 alertes réglementaires par jour, un volume 25 fois supérieur à celui d’il y a dix ans. Plus de la moitié des professionnels GRC citent d’ailleurs la veille réglementaire comme leur défi numéro un. Parallèlement, l’explosion des données à analyser et la généralisation du travail hybride complexifient la gestion des risques. Dans ce contexte, l’Intelligence Artificielle (IA) émerge non seulement comme un outil pour gagner en efficacité et extraire de nouveaux insights, mais aussi comme un sujet de réglementation à part entière (avec, par exemple, l’AI Act européen prévu pour 2026). Face à ces défis, l’adoption de l’IA en GRC n’est plus une option futuriste mais un levier concret pour automatiser la conformité, mieux classifier l’information et réaliser un audit intelligent en continu.

Conformité 2.0 : l’automatisation intelligente du compliance

une enquête Deloitte, 62% des organisations constatent que l’IA a déjà nettement amélioré l’efficacité de leurs processus de conformité – principalement en automatisant les tâches complexes et répétitives, comme les contrôles et évaluations de risques

Les responsables conformité voient leur rôle évoluer d’un contrôle a posteriori vers un pilotage proactif de la stratégie d’entreprise. En effet, l’IA et l’automatisation transforment la fonction compliance en un véritable nerf stratégique. D’après une enquête Deloitte, 62% des organisations constatent que l’IA a déjà nettement amélioré l’efficacité de leurs processus de conformité – principalement en automatisant les tâches complexes et répétitives, comme les contrôles et évaluations de risques.

Concrètement, les solutions d’automatisation de la conformité dopées à l’IA offrent plusieurs avantages déterminants. Premièrement, elles fournissent une veille réglementaire en temps réel : des agents intelligents surveillent en continu les nouvelles lois ou normes et les mappent automatiquement aux cadres de contrôle internes, évitant ainsi les oublis lorsqu’une règle change. Deuxièmement, l’IA permet de détecter de manière prédictive les écarts de conformité. Plutôt que d’attendre l’audit annuel pour découvrir une non-conformité, des algorithmes analysent en continu les données (transactions financières, configurations systèmes, logs…) pour signaler en amont les anomalies ou risques d’incidents. Troisièmement, l’IA automatise la gestion de la preuve : collecte de documents, journalisation des contrôles effectués, préparation de rapports – autant de tâches autrefois chronophages qui sont désormais réalisées instantanément, avec moins d’erreurs humaines. Cette capacité allège la charge manuelle et garantit que, lorsqu’un audit survient, l’organisation est “audit-ready” en permanence au lieu de courir après les justificatifs. Enfin, en orchestrant des workflows transverses, ces outils brisent les silos entre départements (RSSI, juridique, opérations…) et avec les tiers, instaurant une conformité intégrée dans toute l’entreprise. Les bénéfices sont clairs : l’IA libère les experts conformité des tâches rébarbatives pour qu’ils se concentrent sur l’analyse stratégique, le conseil au management et le renforcement de la culture éthique. Loin d’un simple effet de mode, l’IA fait de la conformité un domaine plus agile, exhaustif et en temps réel, réduisant le risque de sanctions et renforçant la résilience réglementaire de l’entreprise.

Classification documentaire intelligente : la donnée sous contrôle

Preuve de leur maturité, ces systèmes atteignent déjà plus de 85% de confiance dans l’identification automatisée de documents critiques (comptables, RH, contrats, etc.), y compris pour des formats ou modèles inédits

La conformité et la gestion des risques reposent en grande partie sur une bonne gouvernance des données : encore faut-il savoir quoi protéger et comment. Or, les entreprises croulent sous les données non structurées – contrats, e-mails, rapports – que les méthodes traditionnelles peinent à inventorier et catégoriser. Ici aussi, l’IA change la donne. Les nouveaux outils de classification automatique exploitent des modèles entraînés sur des volumes massifs de documents pour comprendre le contexte et la sensibilité de l’information, bien au-delà de quelques mots-clés. Par exemple, des classifieurs à base de Large Language Models (LLM) peuvent distinguer et labelliser finement des documents aussi variés que des brevets, des dossiers médicaux, des contrats juridiques ou des source code, en apprenant la nuance des contenus métiers. Preuve de leur maturité, ces systèmes atteignent déjà plus de 85% de confiance dans l’identification automatisée de documents critiques (comptables, RH, contrats, etc.), y compris pour des formats ou modèles inédits. Cette approche sémantique réduit drastiquement les faux positifs par rapport aux règles fixes, et comble les angles morts en débusquant des informations sensibles qui passaient auparavant sous le radar (par exemple un secret industriel non détecté faute de mot-clé explicite).

Surtout, l’IA enrichit et actualise en continu cette classification au fil de l’évolution de l’organisation et des menaces : grâce à l’auto-apprentissage, les modèles s’adaptent aux nouveaux types de documents ou de données qui apparaissent, améliorant sans cesse leur précision. Les retombées en GRC sont majeures. D’une part, une cartographie précise des données sensibles (PII/ données personnelles, données financières réglementées, informations stratégiques…) permet de déployer les contrôles de sécurité et de conformité adéquats (chiffrement, restrictions d’accès, conservation limitée) exactement là où il faut, comme l’exigent des textes tels que le RGPD ou HIPAA. D’autre part, en cas d’audit ou d’incident, l’entreprise sait instantanément quelles données sont touchées, ce qui facilite l’analyse d’impact, la réponse appropriée et la preuve de conformité auprès des régulateurs. En somme, l’IA agit comme un système nerveux intelligent pour la gestion documentaire : elle voit et comprend l’information à protéger, fournissant aux équipes GRC une visibilité et un contrôle sans précédent sur le patrimoine informationnel de l’entreprise.

Audit interne intelligent : vers l’ère de l’audit continu

Cette tendance va s’accélérer : on estime que d’ici 2025 plus de 50% des grandes entreprises utiliseront l’IA et le machine learning pour effectuer des contrôles de conformité réglementaire en continu, alors qu’elles étaient moins de 10% à le faire en 2021

Historiquement, l’audit interne – pilier du GRC – opérait de façon périodique et souvent échantillonnée, faute de moyens pour tout vérifier à 100%. L’IA est en train de métamorphoser cette fonction en permettant un audit continu, exhaustif et proactif. Grâce aux algorithmes d’analyse des données et de reconnaissance des anomalies, un logiciel peut désormais passer au crible l’intégralité des transactions et journaux d’une entreprise, et non plus seulement un sous-échantillon, pour y déceler des irrégularités subtiles que l’œil humain pourrait manquer. Cette automatisation intelligente se traduit par une capacité à détecter en temps réel les signaux faibles de fraude, de non-conformité ou d’erreur comptable, là où l’audit classique les repérait des mois plus tard. Par exemple, des outils dotés d’IA repèrent des schémas atypiques dans les écritures financières ou les accès aux systèmes et lancent aussitôt une alerte aux auditeurs – ouvrant la voie à des contrôles immédiats plutôt qu’à de tardives découvertes post-mortem. Les études montrent que la profession s’engage résolument dans cette voie : un sondage Gartner auprès de directeurs d’audit révèle que 41% des départements d’audit dans le monde utilisent déjà ou prévoient d’adopter l’IA générative dès 2024, notamment pour automatiser la rédaction des rapports, analyser de gros volumes de documents textuels et détecter des cas de non-conformité cachés dans les données. Cette tendance va s’accélérer : on estime que d’ici 2025 plus de 50% des grandes entreprises utiliseront l’IA et le machine learning pour effectuer des contrôles de conformité réglementaire en continu, alors qu’elles étaient moins de 10% à le faire en 2021.

« Quels écarts notables dans les dépenses fournisseurs ce trimestre ? »

armanino.com

Pour les auditeurs internes, l’IA joue un rôle de partenaire augmenté : elle ne remplace pas le jugement humain, mais le potentialise. En éliminant une grande partie du travail de compilation et de vérification basique, les auditeurs peuvent consacrer leur temps à l’analyse des causes profondes, au conseil sur la gestion des risques et à l’évaluation de l’efficacité des contrôles. L’IA agit comme un “filet de sécurité” permanent qui surveille l’organisation en continu, tandis que l’auditeur reprend la main pour interpréter les résultats et décider des suites à donner. Ainsi, la fonction audit glisse d’une posture de contrôle a posteriori à un rôle de vigie proactive apportant une assurance en continu. Plusieurs directions Audit innovantes se dotent déjà de chatbots internes ou de copilotes alimentés par leurs données maison, capables de répondre à une question comme « Quels écarts notables dans les dépenses fournisseurs ce trimestre ? » ou d’ébaucher un programme d’audit à partir de textes réglementaires. Les résultats sont éloquents : certaines tâches d’audit autrefois réalisées en 30-40 heures sont accomplies en quelques heures par l’IA, avec une fiabilité accrue et une traçabilité totale, la machine appliquant systématiquement les mêmes critères sans lassitude humaine. L’audit interne, réinventé par l’IA, devient plus efficient, focalisé sur la valeur et mieux armé pour anticiper les risques émergents.

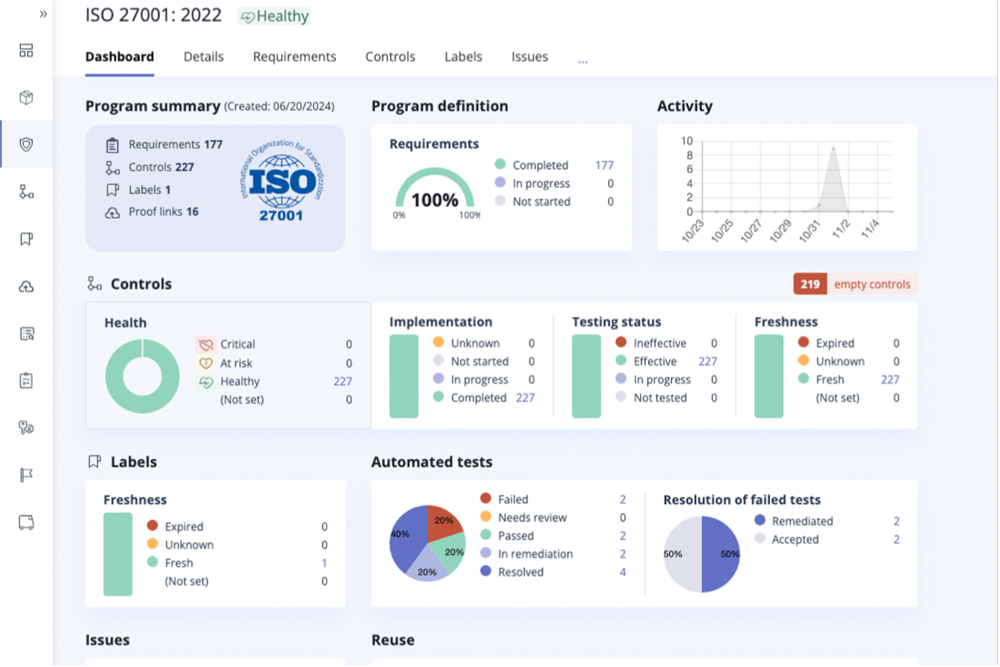

Des plateformes GRC intelligentes pour une gouvernance prédictive

Au-delà des cas d’usage spécifiques, c’est l’ensemble de l’écosystème GRC qui s’aligne sur l’IA. Les éditeurs de solutions de GRC intègrent désormais l’IA au cœur de leurs plateformes pour offrir une vision unifiée, prédictive et pilotée par les données de la gouvernance d’entreprise. On voit émerger des suites “GRC intelligentes” capables de corréler en temps réel les informations provenant de la gestion des risques, de la conformité, des contrôles internes et de la sécurité. Cette approche globale, parfois qualifiée de GRC augmentée ou “agentique”, vise à dépasser l’automatisation de tâches isolées pour atteindre un niveau d’orchestration autonome de la fonction GRC. Concrètement, une plateforme GRC intelligente peut découvrir en continu de nouveaux risques (en scannant l’environnement externe, les actualités réglementaires, les indicateurs opérationnels) et les mettre en regard de la cartographie des risques de l’organisation. Elle peut également valider de manière autonome l’efficacité des contrôles en place : par exemple, vérifier chaque jour que les sauvegardes ont bien été effectuées, que les droits d’accès sont conformes aux politiques, ou que les temps de réponse incidents respectent les SLA définis. En cas d’écart, le système enclenche des actions automatisées : ouverture d’un ticket, envoi d’alertes aux responsables, voire application de mesures correctives simples (blocage d’un compte utilisateur suspect, par exemple). Le tout s’opère sous supervision humaine, car l’outil journalise chaque recommandation ou décision d’IA pour permettre aux experts de la valider (explainable AI oblige).

Ces plateformes offrent aux dirigeants des tableaux de bord intelligents, agrégeant des données complexes en indicateurs clairs sur le profil de risque de l’organisation, son état de conformité en regard de chaque norme, ou la projection des risques émergents à horizon proche grâce à l’analytique prédictive. Un comité de direction peut ainsi, d’un coup d’œil, comprendre l’impact qu’aurait une décision stratégique (lancement d’un nouveau service, entrée sur un marché) sur le niveau de risque global, car l’IA aura simulé ces scénarios. Un autre apport clé de l’IA est de faire du GRC un processus plus continu que cyclique : on tend vers une conformité en continu plutôt qu’en fin de trimestre, et un pilotage des risques en temps réel plutôt qu’annuel. Les bénéfices stratégiques se dessinent déjà : des entreprises dotées de GRC intelligents se disent capables d’entrer plus vite sur de nouveaux marchés (car elles évaluent et implémentent rapidement les contrôles requis) et de gagner la confiance des parties prenantes en démontrant à tout moment une conformité maîtrisée. En un sens, l’IA permet de transformer la GRC d’un centre de coûts en un moteur de croissance et de confiance. Bien entendu, réussir cette mutation nécessite une intégration réfléchie de ces technologies. Les organisations leaders commencent par consolider leurs données GRC (risques, contrôles, incidents) afin d’entraîner l’IA sur une base fiable, et privilégient des solutions conçues spécifiquement pour leurs enjeux sectoriels. Elles instaurent dès le départ une gouvernance de l’IA rigoureuse (choix d’indicateurs, comités de pilotage, critères d’acceptation) pour s’assurer que l’autonomie accordée à la machine reste sous contrôle. Le résultat n’en reste pas moins une GRC plus agile, préventive et alignée sur les objectifs business – un atout considérable dans un monde où l’incertitude est permanente.

Défis et meilleures pratiques pour une IA GRC responsable

Malgré ses promesses, l’IA en GRC soulève d’importants défis qu’il convient d’anticiper. D’abord, la qualité des données est le socle de toute décision fiable : un adage bien connu “garbage in, garbage out” s’applique ici. Des algorithmes entraînés sur des données incomplètes ou biaisées risquent de produire des analyses erronées, induisant une fausse assurance ou des alertes inutiles. Mettre en place une solide gouvernance des données (catalogue, qualité, sécurité) est donc une étape préalable incontournable. Ensuite, l’explicabilité des modèles d’IA est cruciale en contexte de compliance. Il ne suffit pas qu’une IA signale un risque : les équipes GRC doivent pouvoir expliquer comment et pourquoi cette conclusion a été atteinte, que ce soit à un auditeur interne, à un régulateur ou à un comité éthique. Cela implique de privilégier des solutions d’IA explicable (XAI), qui tracent leurs raisonnements et permettent d’auditer les critères utilisés. Par ailleurs, l’IA elle-même devient objet de gouvernance : on parle de “AI Governance” pour désigner l’ensemble des contrôles et processus visant à encadrer le développement et l’utilisation des systèmes d’IA. Les organisations doivent établir des politiques spécifiques (validation des modèles avant mise en production, monitoring de la dérive des modèles, comité d’éthique IA, etc.) afin de garantir que leurs agents intelligents restent sous contrôle et conformes aux régulations à venir. Un autre enjeu majeur concerne la confidentialité et la sécurité. L’usage inconsidéré d’IA, notamment de modèles généraux type GPT, peut mener à des fuites de données sensibles si l’on n’y prend garde. On a vu des cas où un chatbot interne a révélé des informations confidentielles simplement parce que les données d’entraînement n’avaient pas été correctement filtrées ou classifiées.

Une bonne pratique consiste donc à baliser strictement les cas d’usage de l’IA (ex : autoriser les modèles généraux uniquement sur des données publiques ou anonymisées) et à intégrer l’IA dans le périmètre des audits de sécurité et de protection des données. Enfin, le volet réglementaire évolue rapidement : l’AI Act de l’UE prévoit par exemple des obligations de transparence, de gestion du risque et de supervision humaine pour les IA jugées « à haut risque ». D’autres cadres (ISO 42001 pour un système de management responsable de l’IA, NIST AI Risk Framework, etc.) émergent pour guider les organisations dans la formalisation de contrôles autour de l’IA. Mener une stratégie IA GRC gagnante exige donc une approche graduelle et maîtrisée. Il est recommandé de démarrer par des projets pilotes sur des périmètres circonscrits (par ex. automatiser l’analyse de logs SOX ou la classification de contrats), afin d’évaluer les résultats et les risques en situation réelle. En parallèle, il faut impliquer tôt les équipes Risk, Compliance, DPO, Sécurité dans ces initiatives pour qu’elles apportent leur expertise (sur les biais, les obligations légales, etc.) et définissent des garde-fous appropriés. Le principe du “huma-in-the-loop” demeure d’actualité : les décisions critiques en GRC doivent continuer de faire l’objet d’une revue et d’une validation par un humain, l’IA intervenant en support pour traiter le volumineux et accélérer le workflow. Enfin, investir dans la montée en compétence des collaborateurs (formation à l’IA, recrutement de profils data/IA au sein des fonctions audit et conformité) est un levier essentiel pour intégrer durablement ces technologies. En respectant ces bonnes pratiques, une entreprise peut capitaliser sur la puissance de l’IA en GRC tout en en maîtrisant les risques – conciliant ainsi innovation et confiance, efficacité et éthique.

Conclusion et perspectives stratégiques

L’IA GRC s’impose comme une évolution incontournable pour les entreprises souhaitant naviguer dans un environnement à la fois plus complexe et plus exigeant. En automatisant la conformité, en rendant l’audit réellement continu et en révélant la valeur des données, l’IA fait passer la gestion des risques et de la conformité d’un rôle purement défensif à un rôle proactif et créateur de valeur. Elle permet d’anticiper plutôt que subir, de transformer des obligations en avantage compétitif – à condition de l’implémenter avec discernement. Les dirigeants qui sauront tirer parti de ces technologies auront un temps d’avance : processus plus agiles, décisions mieux informées, et surtout confiance accrue des régulateurs, clients et partenaires grâce à une transparence et une réactivité exemplaires. Bien sûr, la route vers une GRC augmentée par l’IA est progressive et suppose un engagement continu (technologique, humain, organisationnel). Mais les gains en efficacité et en résilience seront déterminants dans les années à venir. En somme, l’IA ne remplace pas les experts GRC – elle les élève en éliminant le superflu et en amplifiant leur insight. Pour les responsables Risques, Compliance ou DSI, le message est clair : il est temps d’embrasser l’IA de manière responsable pour réinventer la GRC et transformer la conformité d’une contrainte en un atout stratégique. Ce nouveau paradigme est en marche – ne le laissez pas se faire sans vous. Abonnez-vous à notre veille d’experts ou contactez nos consultants pour continuer la conversation et explorer comment l’IA peut propulser votre fonction GRC vers de nouveaux sommets.

Contactez-nous pour plus d’information.